AI-StudyLab-Neo 2025年04月01日 10:26

微信公众号: [AI健自习室] 关注Crypto与LLM技术、关注

AI-StudyLab。问题或建议,请公众号留言。

摘要

模型上下文协议(Model Context Protocol,简称MCP)是Anthropic于2024年推出的一种开放标准,旨在规范AI模型与外部数据源、工具之间的交互方式。本报告综合多篇专业文章,全面解析MCP的核心概念、架构设计、工作原理、开发实践和应用场景,探讨其在企业环境和开发者工具集成等领域的潜力,并分析未来发展趋势与挑战。MCP通过标准化的客户端-服务器架构,提供资源访问、工具调用、提示响应和采样反馈等能力,为构建更安全、更灵活、更强大的AI应用提供了坚实基础。

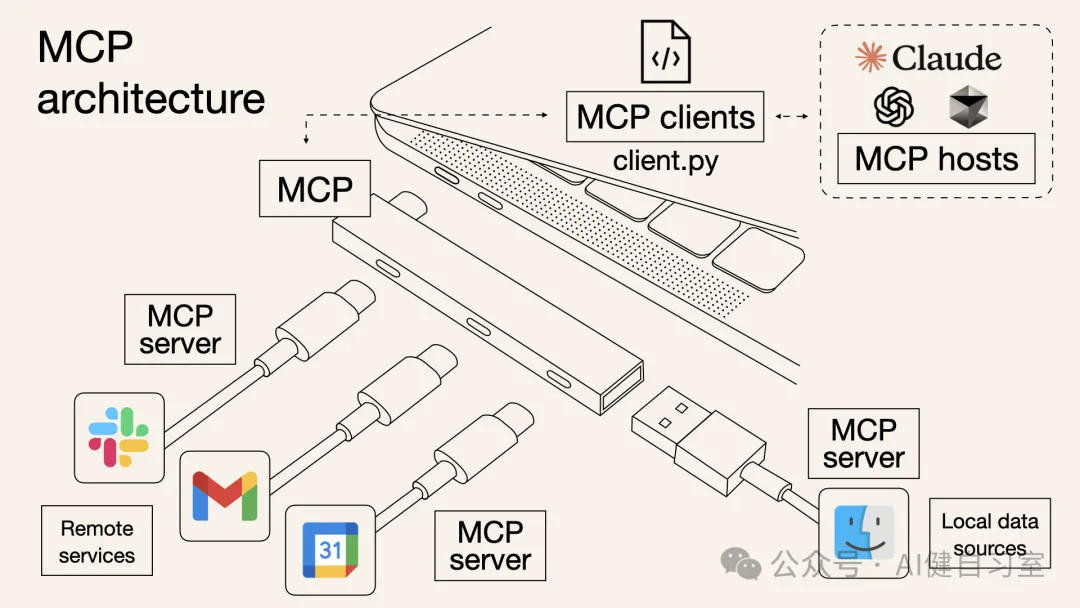

1. MCP概述:AI领域的”USB-C接口”

1.1 定义与核心价值

MCP(Model Context Protocol,模型上下文协议)是由Anthropic于2024年11月推出并开源的一套开放协议标准,定义了AI应用程序(如大语言模型)与各种外部数据源和工具之间交换上下文信息的标准方式。MCP不是一个具体的软件,而是一套规则和消息格式,用于在”主机”(Host)和”服务器”(Server)之间建立安全、结构化的通信通道。

MCP的核心价值可以从以下几个维度理解:

| 价值维度 | 具体表现 |

|---|---|

| 解耦 | 将LLM核心推理能力与外部功能实现细节分离,使模型与工具各自独立发展 |

| 标准化 | 提供通用接口规范,促进不同组件间互操作性,降低集成成本 |

| 安全性 | 内置安全机制(如用户审批、访问控制),保护敏感数据和系统 |

| 灵活性 | 支持多种交互类型(资源读取、工具调用、提示获取),适应不同场景 |

| 可组合性 | 允许一个主机连接多个MCP服务器,聚合不同来源的工具和资源 |

MCP可以被形象地比喻为:

- “AI世界的USB-C接口” :提供统一接口,连接不同设备

- “全屋智能中枢” :统一连接各种功能,简化操作

- “LLM的安全网关” :控制和规范AI与外部世界的交互

1.2 MCP与Function Calling的对比

| 特性 | MCP | Function Calling |

|---|---|---|

| 定义 | 模型和其它设备集成的标准接口,包含工具、资源和提示词 | 特定模型厂商的功能,主要是模型生成函数调用的能力 |

| 协议 | JSON-RPC,支持双向通信、可发现性、更新通知能力 | JSON-Schema,静态函数调用 |

| 调用方式 | Stdio / SSE / 同进程调用 | 同进程调用 / 编程语言对应函数 |

| 适用场景 | 更适合动态、复杂的交互场景 | 单一特定工具、静态函数执行调用 |

| 系统集成难度 | 相对较高 | 简单 |

| 工程化程度 | 高 | 低 |

| 平台依赖性 | 低,标准化协议 | 高,不同LLM平台实现差异较大 |

| 安全考量 | 内置服务器控制和用户审批机制 | 较为简单 |

正如一位开发者形象地比喻:“Function calling就像家里各种电器的遥控器,每个都要单独编接口;MCP则像全屋智能中枢,通过统一协议接入所有设备。“

1.3 背景与目标

MCP的诞生背景在于解决当前AI模型与外部世界交互时面临的几个关键挑战:

- 信息孤岛 :AI模型本身无法直接访问实时数据或本地资源,限制了其应用场景

- 集成复杂性 :为每个工具或数据源编写单独的集成代码,导致开发成本高、维护困难

- 生态碎片化 :不同模型和平台使用不同的工具调用机制,缺乏统一标准

- 安全隐患 :缺乏标准化的安全机制来控制AI对外部系统的访问

MCP的设计目标是通过开放协议的方式,提供一个标准化、安全、灵活的机制,让AI模型能够与外部世界进行更有效的交互,同时降低开发和集成的复杂性。

2. MCP核心架构与工作原理

2.1 基本架构组件

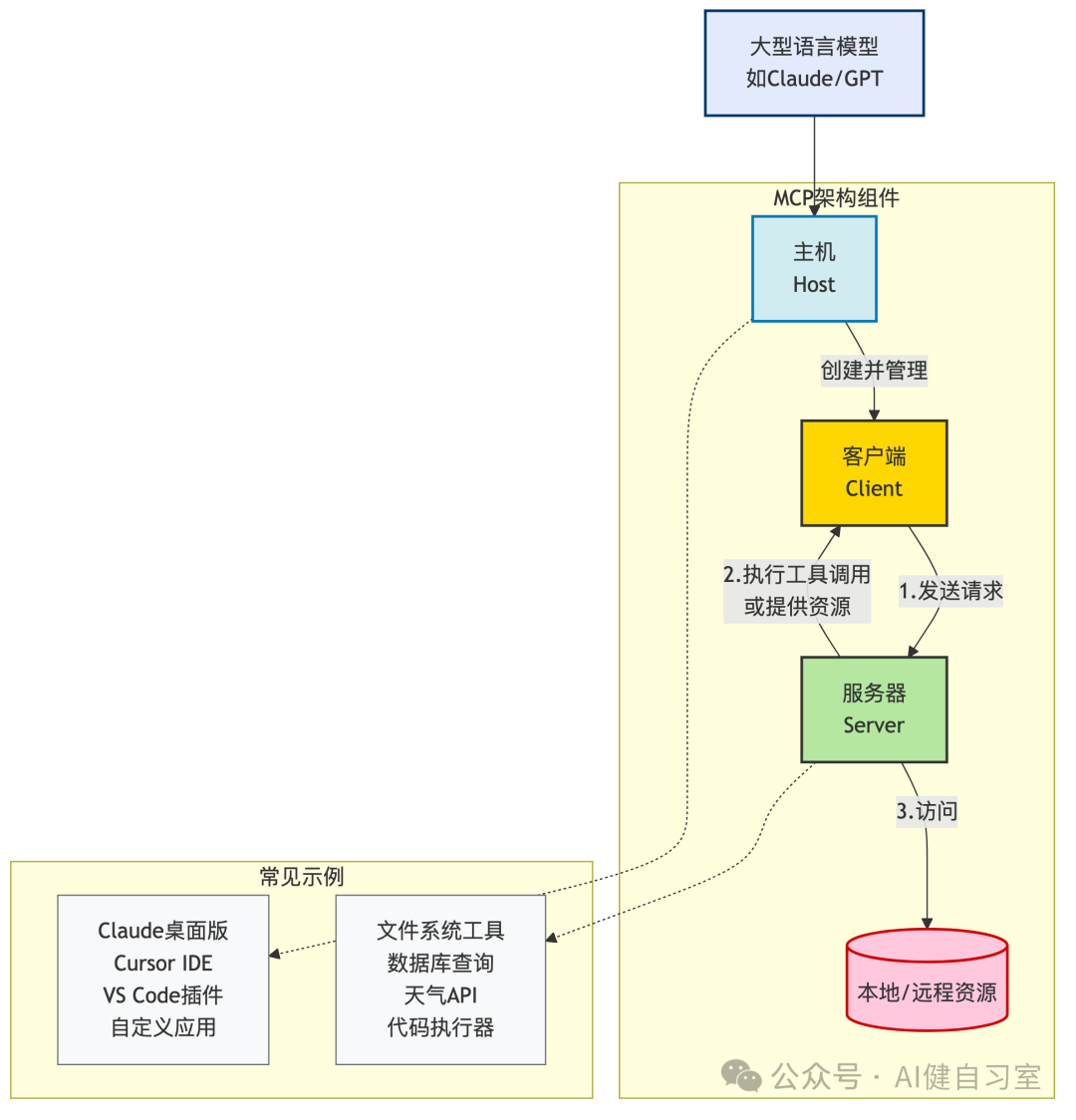

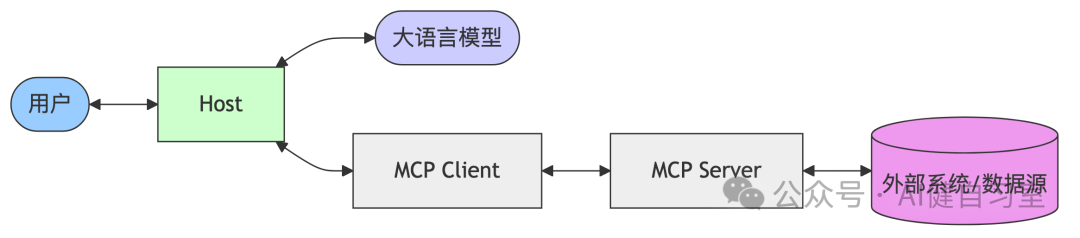

MCP架构采用客户端-服务器模式,包括三个核心组件:

- 主机(Host) :运行LLM或与LLM交互的应用程序,如Claude Desktop、Cursor IDE、VS Code + Cline插件等。主机负责管理MCP客户端、与LLM通信、处理用户交互(如审批工具调用),并将从服务器获取的信息整合到LLM上下文中。

- 客户端(Client) :位于主机内部,与一个或多个MCP服务器建立1:1连接。客户端负责根据主机指令向服务器发送请求,处理协议协商和能力交换,管理与服务器的会话状态和订阅,并路由消息。

- 服务器(Server) :提供特定功能的独立应用程序,负责响应客户端请求并访问资源。服务器通过MCP协议原语暴露资源、工具和提示,独立运行并有专注的职责,可以是本地进程或远程服务。

2.2 关键概念与原语

MCP定义了以下几个核心概念(“原语”)来组织和描述外部能力:

- 资源(Resources) :服务器可提供给客户端读取的数据或内容,如文件内容、数据库结构、API响应。资源通过URI标识,通常由应用或用户控制,需要用户明确选择或授权后才能提供给模型。

- 工具(Tools) :服务器可执行的动作或函数,如发送邮件、执行代码、数据库修改。工具由LLM根据用户意图决定调用(通常需要用户批准),包含名称、描述和JSON Schema定义的输入参数。

- 提示(Prompts) :服务器定义的可复用提示模板或预设工作流,如

/git-commit、/explain-code等。提示通常由用户在客户端界面选择触发,服务器可根据提示和参数动态生成交互流程。 - 采样(Sampling) :允许服务器主动请求客户端(代表LLM)进行一次推理,获取结果。这使得服务器能驱动更复杂的多步骤Agent行为,例如让服务器根据当前状态决定下一步需要LLM思考什么。

- 根(Root) :客户端告知服务器的URI,用于建议服务器操作的上下文范围或边界(如项目目录路径)。Root是指导性的,帮助服务器聚焦,但并非强制的安全约束。

2.3 通信协议与机制

MCP通信基于JSON-RPC 2.0规范,包括以下特性:

- 消息类型 :定义了请求(Request)、响应(Response - 包含Result或Error)和通知(Notification)三种消息类型

- 传输层 :MCP支持两种主要传输方式:

- Stdio(标准输入/输出) :客户端启动服务器作为子进程,通过进程标准输入/输出进行通信

- Streamable HTTP :最新规范使用灵活的HTTP传输方式,服务器可选择升级为双向流或保持无状态的请求-响应模式

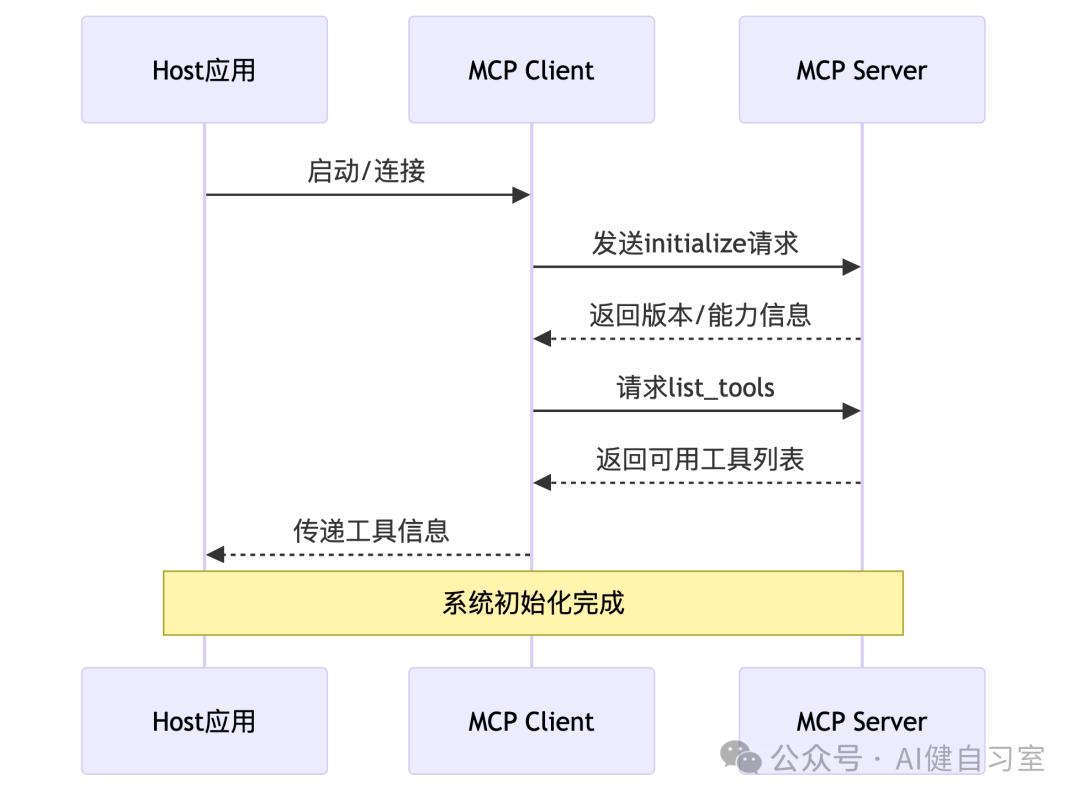

- 生命周期 :连接建立后有明确的生命周期,包括初始化握手(交换协议版本、能力)、正常操作(消息交互)和关闭

- 性能优化 :支持JSON-RPC批处理,将多个请求打包发送,减少网络往返次数

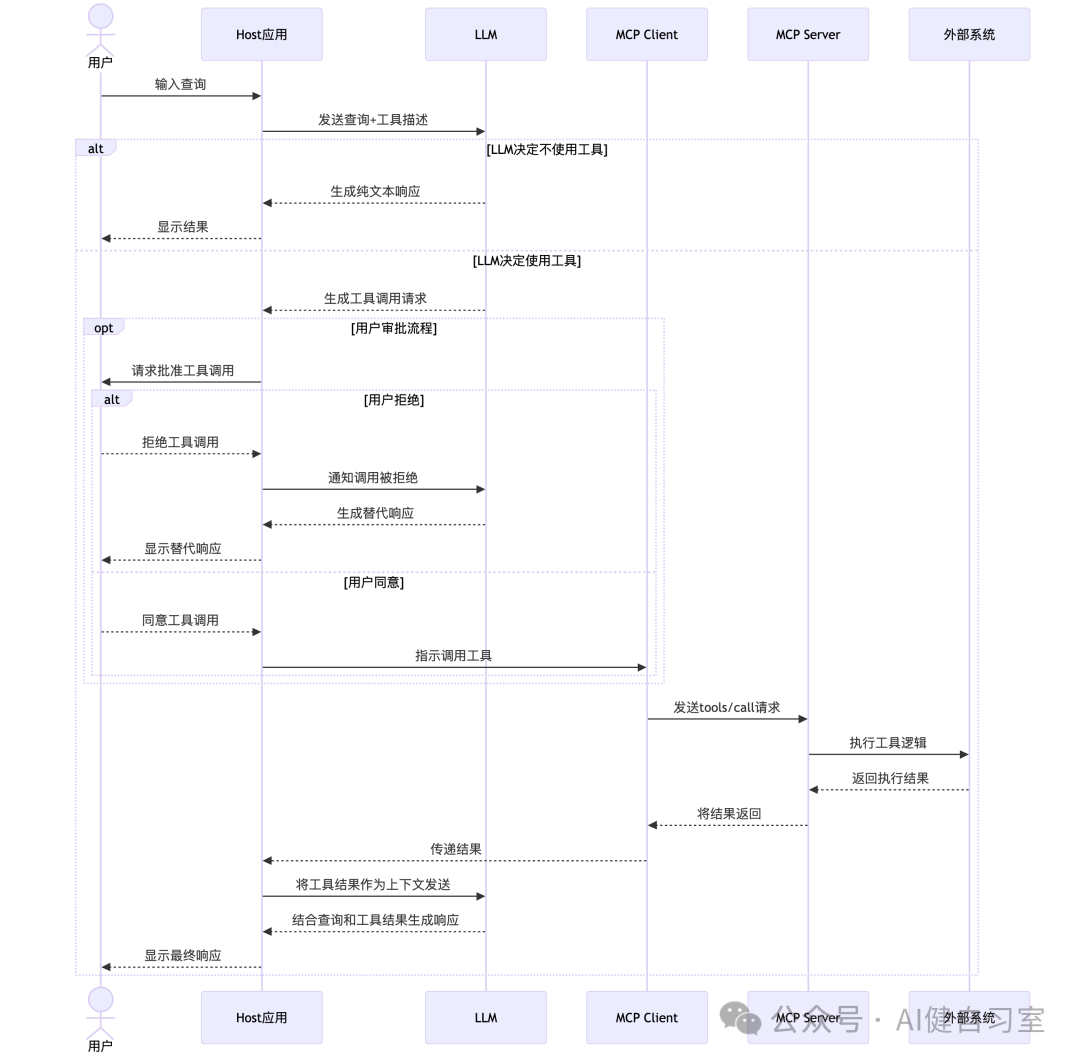

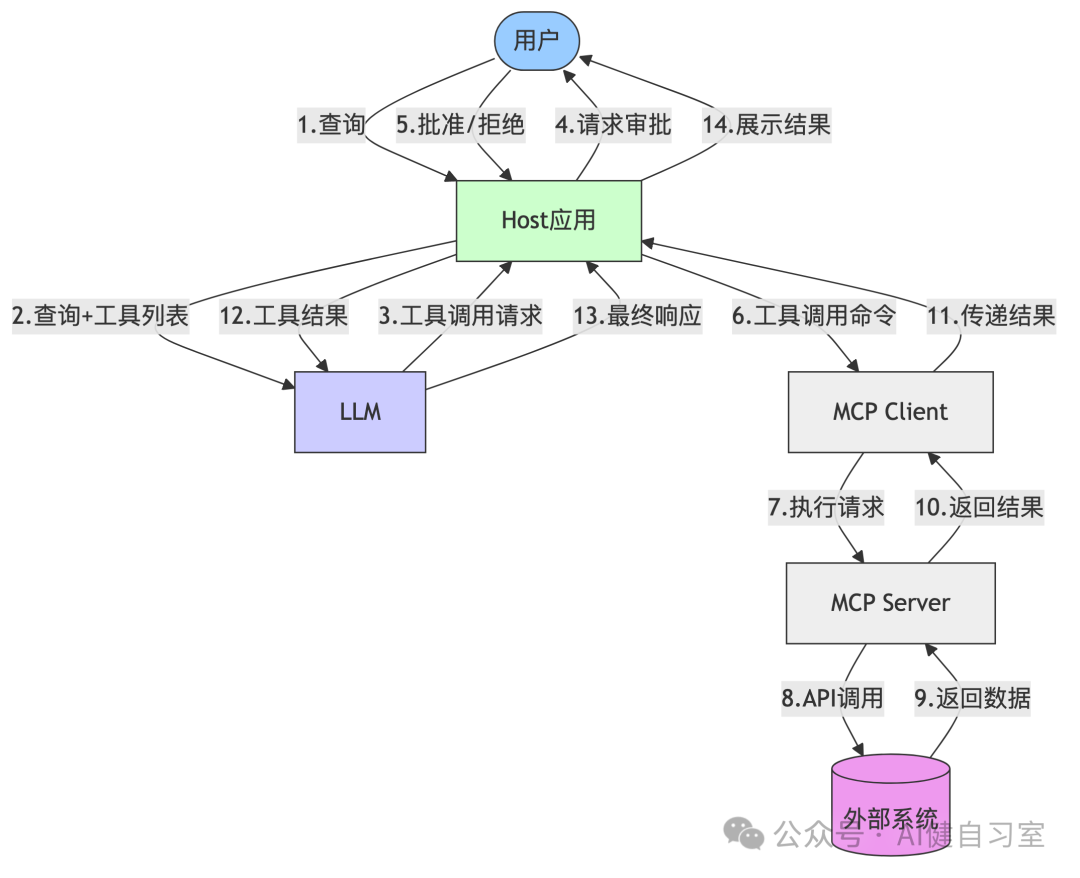

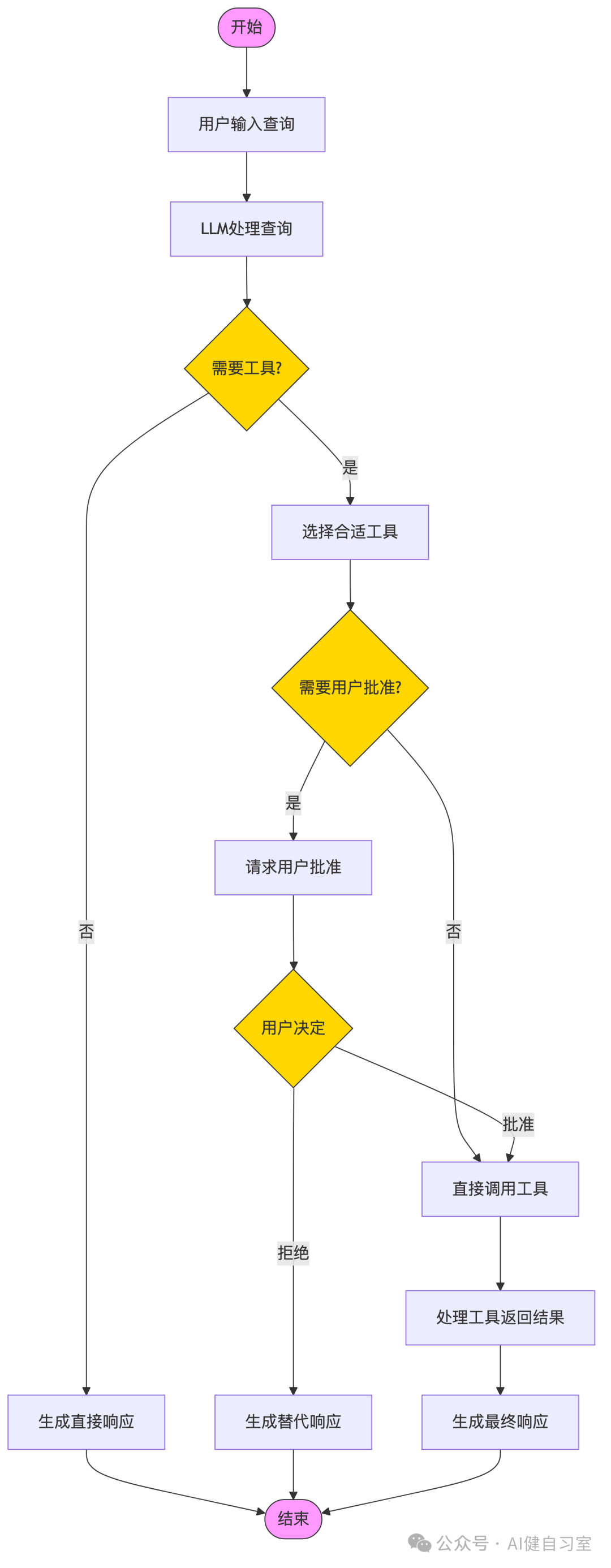

2.4 MCP工作流程

1. 系统架构总览

2. 初始化与发现流程

3. 用户交互与工具调用流程

4. 数据流向图

5. MCP工具调用决策流程

关键组件说明

- Host应用 :用户交互界面,连接用户、LLM和MCP客户端

- MCP Client :负责与MCP服务器通信的客户端组件

- MCP Server :处理工具调用请求并连接外部系统的服务端

- LLM :大语言模型,负责理解用户意图并决定是否使用工具

- 外部系统 :提供实际功能的API或数据源

3. MCP开发与实践指南

3.1 开发环境准备

开发MCP服务器和客户端需要配置相应的环境:

Python环境 :

1. `# 安装uv (推荐的Python包管理器)`

2. `curl -LsSf https://astral.sh/uv/install.sh | sh`

3. `# 创建虚拟环境`

4. `uv venv`

5. `source .venv/bin/activate # Linux/macOS`

6. `.venv\Scripts\activate # Windows`

7. `# 安装MCP依赖`

8. `uv add "mcp[cli]" httpx`

Node.js环境 :

1. `# 安装MCP SDK`

2. `npm install @modelcontextprotocol/sdk`

3. `# 创建项目骨架`

4. `npx @modelcontextprotocol/create-server my-custom-server`

5. `cd my-custom-server`

3.2 构建MCP服务器

以下是使用Python FastMCP 构建MCP服务器的示例:

1. `# weather_server.py`

2. `from mcp.server.fastmcp import FastMCP`

3. `import httpx`

4. `from typing import Optional`

5. `# 1. 初始化 FastMCP`

6. `mcp = FastMCP("weather-server")`

7. `# 2. 使用 @mcp.tool() 定义工具`

8. `@mcp.tool()`

9. `async def get_forecast(latitude: float, longitude: float, days: Optional[int] = 3) -> str:`

10. `"""`

11. `获取指定经纬度的天气预报。`

12. `Args:`

13. `latitude: 地点的纬度。`

14. `longitude: 地点的经度。`

15. `days: 预报天数,默认3天。`

16. `Returns:`

17. `包含天气预报信息的字符串。`

18. `"""`

19. `# 实现工具逻辑`

20. `async with httpx.AsyncClient() as client:`

21. `try:`

22. `response = await client.get(`

23. `f"https://api.example.com/weather/forecast",`

24. `params={`

25. `"lat": latitude,`

26. `"lon": longitude,`

27. `"days": days`

28. `},`

29. `timeout=10.0`

30. `)`

31. `if response.status_code != 200:`

32. `return f"Error: Unable to fetch weather data (Status code: {response.status_code})"`

33. `data = response.json()`

34. `# 处理数据并格式化结果`

35. `formatted_forecast = format_weather_data(data) # 假设此函数已定义`

36. `return formatted_forecast`

37. `except Exception as e:`

38. `return f"Error occurred: {str(e)}"`

39. `# 3. 启动服务器`

40. `if __name__ == "__main__":`

41. `print("Starting weather MCP server via stdio...")`

42. `try:`

43. `mcp.run(transport='stdio')`

44. `except Exception as e:`

45. `print(f"Server failed to run: {e}")`

46. `import sys`

47. `sys.exit(1)`

3.3 构建MCP客户端

以下是一个基本的MCP客户端实现示例:

1. `# mcp_client_example.py`

2. `import asyncio`

3. `import sys`

4. `from mcp import ClientSession, StdioServerParameters`

5. `from mcp.client.stdio import stdio_client`

6. `async def run_mcp_client():`

7. `# 设置服务器连接参数`

8. `server_params = StdioServerParameters(`

9. `command="python",`

10. `args=["weather_server.py"],`

11. `env=None # 可传入环境变量`

12. `)`

13. `try:`

14. `# 建立连接`

15. `async with stdio_client(server_params) as (read, write):`

16. `async with ClientSession(read, write) as session:`

17. `# 初始化连接`

18. `await session.initialize()`

19. `# 列出可用工具`

20. `tools_response = await session.list_tools()`

21. `print(f"Available tools: {[tool.name for tool in tools_response.tools]}")`

22. `# 调用工具`

23. `result = await session.call_tool(`

24. `"get_forecast",`

25. `{"latitude": 39.9, "longitude": 116.4, "days": 5}`

26. `)`

27. `# 处理结果`

28. `if hasattr(result, 'content') and result.content:`

29. `for item in result.content:`

30. `if item.type == 'text':`

31. `print(f"Weather forecast: {item.text}")`

32. `else:`

33. `print("No content returned or error occurred")`

34. `except Exception as e:`

35. `print(f"Error: {e}")`

36. `if __name__ == "__main__":`

37. `asyncio.run(run_mcp_client())`

3.4 调试与测试

MCP提供了多种工具辅助调试和测试:

- MCP Inspector (

mcp dev):一个Web界面工具,用于测试和调试MCP服务器: mcp dev weather_server.py- 日志记录 :在服务器和客户端代码中添加详细日志,记录请求、响应和错误:

import logging

2.logging.basicConfig(level=logging.DEBUG)- VS Code/IDE调试器 :设置断点,逐步执行服务器或客户端代码

- 逐层测试 :先单元测试服务器逻辑 → Inspector测试MCP接口 → 最小客户端测试连接 → 集成LLM测试完整流程

3.5 客户端集成

MCP可以与各种LLM集成,主要步骤包括:

- 获取工具描述 :从MCP服务器获取工具描述列表

- 转换为LLM格式 :将MCP工具转换为特定LLM的工具格式(如OpenAI的function calling格式)

- 传递给LLM :将工具描述与用户查询一起发送给LLM

- 解析LLM响应 :从LLM响应中解析工具调用请求

- 调用MCP工具 :使用MCP客户端执行工具调用

- 处理结果 :将工具执行结果返回给LLM,生成最终回答

4. MCP部署策略

4.1 部署模式对比

MCP支持多种部署模式,适应不同场景需求:

| 部署模式 | 适用场景 | 优势 | 挑战 |

|---|---|---|---|

| 本地部署 | 个人开发、桌面应用 | 简单直接、隐私保护、低延迟 | 功能有限、维护成本 |

| 内网部署 | 企业环境、敏感数据处理 | 数据安全、系统集成、多用户共享 | 需要IT支持、网络配置 |

| 云端部署 | SaaS服务、公共API | 高可用性、易扩展、全球访问 | 安全管控、网络延迟 |

| 混合部署 | 大型组织、复杂需求 | 灵活适配、平衡取舍 | 架构复杂、管理难度 |

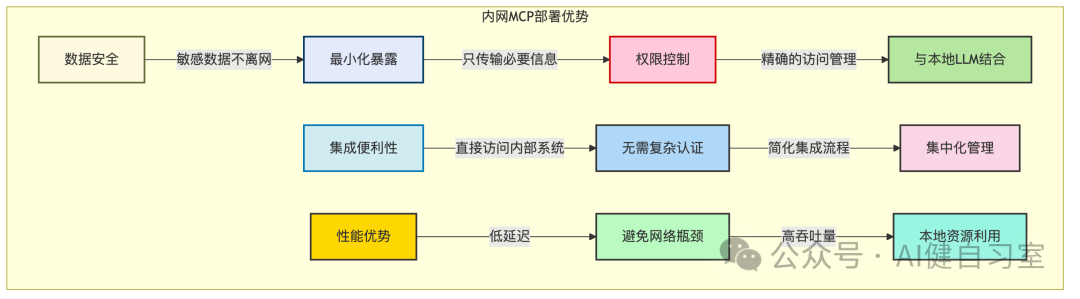

4.2 内网部署优势与实践

内网部署MCP有许多显著优势,尤其适合企业环境:

内网部署MCP的关键步骤:

- 服务器开发 :根据企业需求开发自定义MCP服务器

- 依赖管理 :使用虚拟环境、容器或打包工具管理依赖

- 服务器分发 :通过内部代码仓库或软件分发系统部署服务器

- 配置管理 :安全管理连接参数、API密钥等敏感信息

- 权限控制 :实施基于角色的访问控制,确保安全

- 监控与维护 :建立监控系统,跟踪服务器健康状态

4.3 客户端配置

在Claude Desktop、Cursor等支持MCP的应用中配置MCP服务器的示例:

1. `{`

2. `"mcpServers": {`

3. `"weather-service": {`

4. `"transport": {`

5. `"type": "stdio",`

6. `"command": "python",`

7. `"args": ["/path/to/weather_server.py"]`

8. `},`

9. `"env": {`

10. `"API_KEY": "your-weather-api-key"`

11. `}`

12. `},`

13. `"database-query": {`

14. `"transport": {`

15. `"type": "stdio",`

16. `"command": "node",`

17. `"args": ["/path/to/database-server.js"]`

18. `}`

19. `}`

20. `}`

21. `}`

5. MCP应用场景与案例分析

5.1 应用场景全景图

MCP适用于多种场景,特别是需要LLM与外部系统安全交互的情况:

| 应用领域 | 典型场景 | MCP价值 | 代表实现 |

|---|---|---|---|

| 智能编程助手 | 代码生成、Bug修复、API集成 | 安全访问本地代码库、CI/CD系统 | Cursor、VS Code插件 |

| 数据分析工具 | 自然语言查询数据库、可视化生成 | 安全查询内部数据库、连接BI工具 | XiYanSQL-MCP、数据库MCP服务器 |

| 企业知识管理 | 知识库查询、文档生成、邮件撰写 | 安全访问内部文档、保护隐私数据 | 文件系统MCP、Email-MCP |

| 创意设计工具 | 3D建模、图形生成、UI设计 | 与专业软件无缝集成 | Blender MCP、浏览器自动化 |

| 工作流自动化 | 多系统协调、事件驱动流程 | 跨系统安全协作 | Cloudflare MCP、AWS自动化套件 |

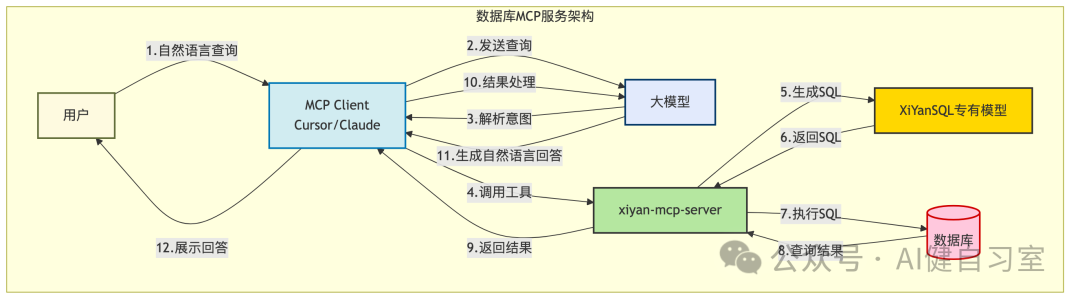

5.2 自然语言数据库查询案例

利用MCP实现数据库自然语言查询:

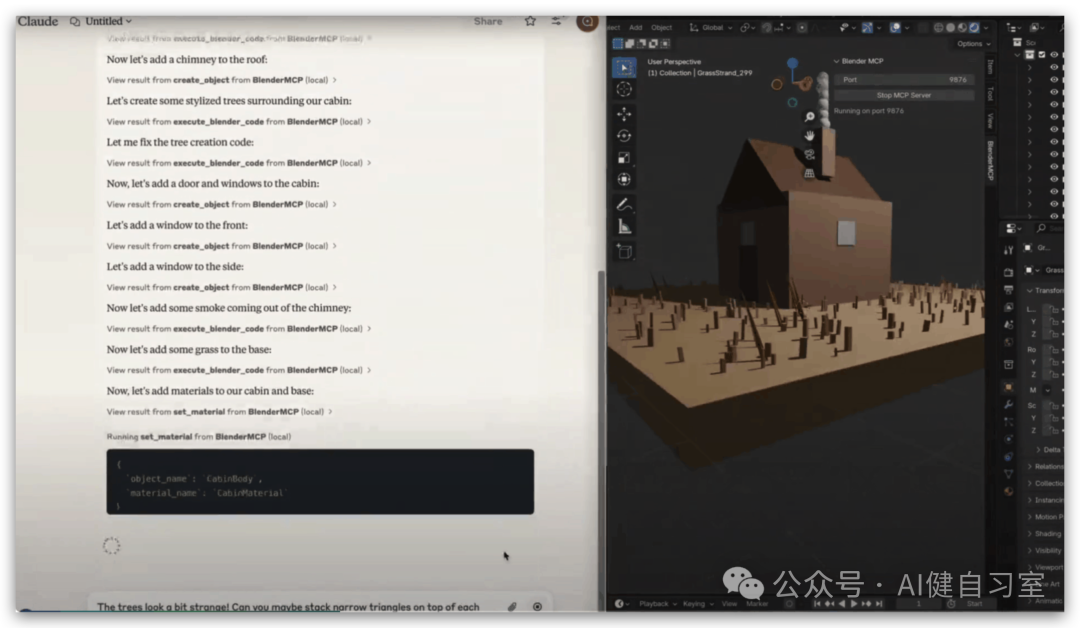

5.3 Blender 3D建模案例

使用MCP实现自然语言控制3D建模软件Blender:

- 用户安装Blender和MCP插件

- 配置Claude Desktop连接到Blender MCP服务器

- 用户通过自然语言描述想要创建的3D场景:“创建一个海滩场景,有棕榈树和落日”

- Claude将请求转换为Blender操作指令

- Blender MCP服务器执行这些指令,创建3D场景

- 结果在Blender界面显示,用户可以进一步修改和优化

6. MCP生态系统现状

6.1 官方支持与资源

MCP由Anthropic于2024年11月推出并开源,目前提供了多种资源:

- SDK :支持Python、TypeScript/JavaScript、Java、Kotlin、C#等语言

- 官方文档 :详细的协议规范、开发指南和教程

- 示例服务器 :多种预构建的MCP服务器,覆盖常见应用场景

- 工具和库 :如MCP Inspector、开发工具包等

6.2 主要MCP服务器生态

MCP服务器生态系统正在快速发展,包括:

| 类别 | 代表性服务器 | 主要功能 | 维护方 |

|---|---|---|---|

| 文件系统 | @modelcontextprotocol/server-filesystem | 本地文件读写、目录操作 | 官方 |

| 版本控制 | @modelcontextprotocol/server-git | Git仓库操作 | 官方 |

| 代码托管 | @modelcontextprotocol/server-github | GitHub API交互 | 官方 |

| 数据库 | @modelcontextprotocol/server-postgres , mcp-server-sqlite | 数据库查询、模式检查 | 官方/社区 |

| 搜索 | @modelcontextprotocol/server-brave-search , tavily-mcp | 网页搜索 | 官方/第三方 |

| Web内容 | @modelcontextprotocol/server-fetch | 获取网页内容 | 官方 |

| 浏览器自动化 | Playwright-MCP (Microsoft) | 控制浏览器交互 | 微软 |

| 协作工具 | @modelcontextprotocol/server-slack | Slack消息/频道 | 官方 |

6.3 支持MCP的客户端

目前多种平台和应用已支持MCP协议:

| 客户端 | 资源支持 | 提示支持 | 工具支持 | 采样支持 | 异步支持 | 备注 |

|---|---|---|---|---|---|---|

| Claude Desktop | ✅ | ✅ | ✅ | ⚠️ | ✅ | 功能最完整 |

| VS Code Insiders | ✅ | ✅ | ✅ | ❌ | ⚠️ | 通过插件支持 |

| Cursor IDE | ✅ | ❌ | ✅ | ❌ | ✅ | 特别优化编程场景 |

| Cline | ✅ | ✅ | ✅ | ❌ | ⚠️ | VS Code插件 |

| Continue | ✅ | ✅ | ✅ | ❌ | ✅ | 良好的开发者体验 |

| Cherry Studio | ✅ | ✅ | ✅ | ❌ | ⚠️ | 国内解决方案 |

| OpenAI Agents SDK | ❌ | ❌ | ✅ | ❌ | ⚠️ | 专注工具支持 |

图例: ✅ 完全支持, ⚠️ 部分支持, ❌ 不支持

6.4 行业采纳情况

MCP已获得多家企业和组织的采纳:

- 主要推动者 : Anthropic (发起者)、OpenAI、Microsoft (积极支持与贡献)

- 早期采用者 : Block、Apollo (金融科技内部应用)、Zed、Replit、Codeium、Sourcegraph (开发者工具)

- 云平台 : Cloudflare、Neon DB (提供官方服务器)

- 中国厂商/社区 : 智谱AI、月之暗面、阿里云、华为云、奇安信等已有社区贡献的MCP服务器

7. MCP最佳实践与开发技巧

7.1 服务器设计最佳实践

- 单一职责原则 :每个MCP服务器应专注于特定功能领域

- 清晰的工具命名与描述 :使工具名称和描述清晰明了,便于LLM理解

- 完善的参数定义 :为每个参数提供类型提示和详细说明

- 健壮的错误处理 :返回有意义的错误信息,而不是让服务器崩溃

- 适当的日志记录 :记录关键操作和错误,便于调试

- 权限控制 :实施细粒度的访问控制,遵循最小权限原则

- 可扩展性设计 :考虑未来功能扩展,采用模块化架构

7.2 客户端集成技巧

- 动态工具发现 :启动时动态获取可用工具,而不是硬编码

- 用户审批机制 :对敏感操作实施”人在回路”审批

- 错误处理策略 :优雅处理工具执行失败的情况

- 超时控制 :设置合理的超时时间,避免长时间阻塞

- 上下文管理 :智能选择和传递上下文给LLM,避免超长

- 缓存优化 :缓存工具描述和频繁使用的结果,提高性能

- 异步处理 :使用异步模式处理耗时操作,保持界面响应性

7.3 安全最佳实践

- 输入验证 :验证所有从LLM或用户来的输入

- 输出过滤 :过滤返回给LLM的敏感信息

- 审计日志 :记录所有工具调用和资源访问

- 沙箱隔离 :在受控环境中执行不可信代码

- 传输加密 :对远程MCP通信使用TLS加密

- 权限分离 :实施职责分离原则,限制单一服务器的权限范围

- 定期更新 :及时更新依赖和SDK,修补安全漏洞

8. MCP未来发展趋势与挑战

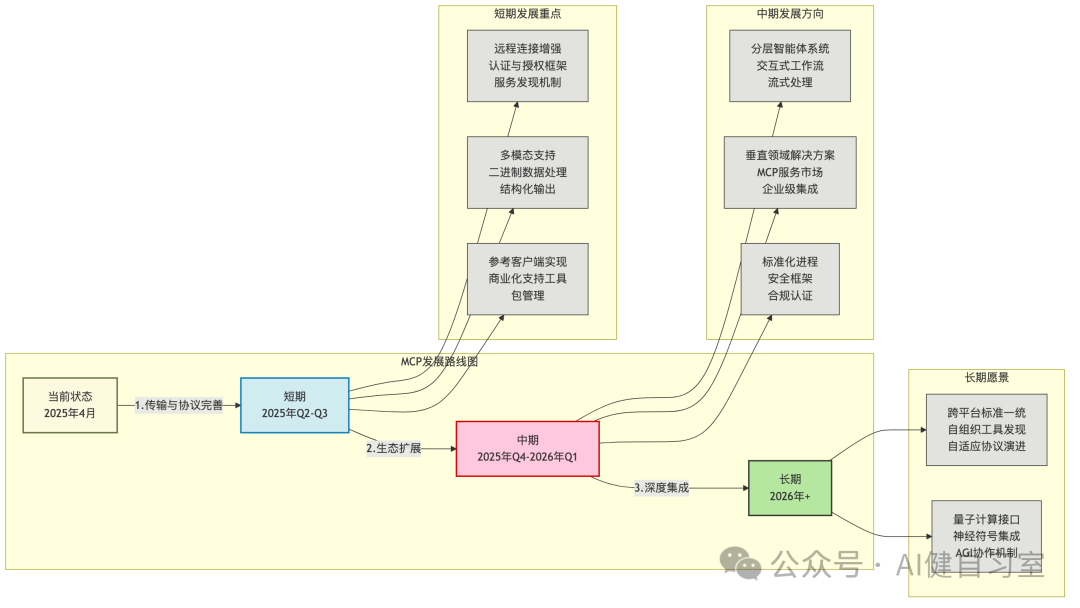

8.1 技术发展路线图

8.2 面临挑战与对策

MCP面临各种挑战,需要相应对策:

| 挑战 | 具体表现 | 可能对策 |

|---|---|---|

| 开发者采纳率 | 与现有方案(如OpenAI函数调用)竞争 | 降低使用门槛,提供丰富示例和工具 |

| 生态系统成熟度 | 服务器质量参差不齐,覆盖不全面 | 建立质量标准,鼓励社区贡献 |

| 技术复杂性 | 学习曲线陡峭,开发成本高 | 改进文档,提供更多高级抽象 |

| 安全风险 | 工具执行可能带来安全隐患 | 完善安全模型,增强沙箱隔离 |

| 标准化竞争 | 与其他框架和标准的竞争 | 推动行业联盟,增强兼容性 |

8.3 对不同参与者的建议

对于不同角色的参与者,针对MCP有以下建议:

开发者 :

- 熟悉MCP规范并尝试开发简单服务器

- 关注官方和社区服务器演进,选择适合需求的工具

- 参与MCP社区建设,贡献代码和文档

企业决策者 :

- 评估MCP在企业内的应用潜力

- 考虑内网部署MCP服务器,连接内部系统

- 制定安全策略和治理框架

- 培训技术团队了解和应用MCP

AI平台提供商 :

- 考虑在平台中支持MCP作为工具调用标准

- 参与协议演进和标准制定

- 提供MCP相关开发工具和服务

工具提供商 :

- 为现有工具和API开发MCP适配层

- 在服务目录中列出MCP兼容性

- 关注MCP生态系统发展,调整产品战略

9. 结论

MCP作为一种开放标准,正在改变AI模型与外部世界交互的方式。它通过提供一种解耦、标准化、安全的机制,有效解决了当前LLM应用集成外部资源的碎片化痛点,为构建更加强大、可靠和可互操作的AI智能体(AI Agent)奠定了重要基础。

MCP的核心价值在于其标准化带来的开发效率提升和生态共享潜力,以及其安全设计(尤其是对本地/内网部署的天然优势)满足了企业和个人对数据隐私的需求。尽管仍面临生态成熟度、开发者采纳和标准化竞争等挑战,但随着Anthropic、OpenAI、Microsoft等行业巨头的支持和贡献,以及活跃的开源社区参与,MCP生态正在迅速壮大。

展望未来,MCP有望从当前的”新兴标准”发展成为连接AI与现实世界的”通用语言”,推动AI Agent能力的深化和应用场景的拓宽。它在企业内部应用、开发者工具集成和敏感数据场景中具有显著优势,是推动AI技术安全落地的关键基础设施之一。

参考资料

- Anthropic官方MCP文档: modelcontextprotocol.io

- MCP GitHub组织: github.com/modelcontextprotocol

- 一文带你入门MCP: zhuanlan.zhihu.com/p/28700850694

- MCP规范: spec.modelcontextprotocol.io/specification/2025-03-26/

- MCP (Model Context Protocol),一篇就够了: zhuanlan.zhihu.com/p/29001189476

- 从零开始开发一个MCP Server: zhuanlan.zhihu.com/p/32199994850

- MCP超级实战 - 自然语言查询数据库: zhuanlan.zhihu.com/p/1887056047639856103

- 模型上下文协议(MCP)深入研究报告(展望2025): zhuanlan.zhihu.com/p/1890070269206434486

继续滑动看下一个

AI健自习室

向上滑动看下一个